Несколько недель вспять компания Open AI представила нейросеть Sora, способную по текстовому описанию производить близкое к реальности видео длительностью до 1-й минутки с разрешением 1920 × 1080 пикселей. в данный момент же компания HarrisX провела опрос, предлагая взрослым янки различить сгенерированное ИИ видео от реального. Оказалось, что большая часть респондентов ошиблась в 5 из 8 предлагаемых в рамках опроса роликов.

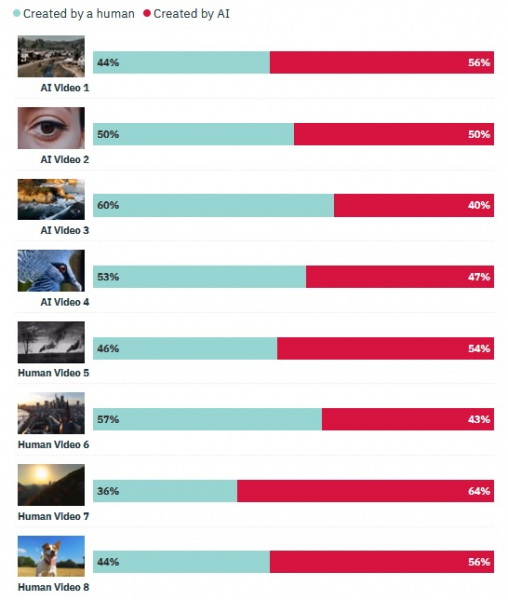

В опросе, который проходил в период с 1 по 4 марта в США, участвовали больше 1000 янки. Творцы исследования сгенерировали 4-е качественных ролика при помощи нейросети Sora, еще избрали 4-е маленьких видео, которые были сняты на камеру в реальном мире. Респондентам в случайном порядке демонстрировали эти видео, а их цель была найти, снят ролик человеком либо его сгенерировал ИИ. Представления участников опроса разделились, но при всем этом в 5 из 8 случаев большая часть респондентов отдала ложный ответ.

Это исследование показывает на то, что производимый при помощи генеративных нейросетей контент становится всё больше близким к реальности и различить его от реального всё сложнее. Точно потому в различных странах стали почаще звучать призывы к властям о необходимости законодательного регулирования этого сектора. В числе остального предлагается обязать юзеров нейросетей помечать генерируемый контент подходящим образом, чтоб он не вводил других в ошибочное мнение и не мог стать источником дезинформации.

Метод Sora ещё недоступен широкой публике, но уже на данный момент он вызывает серьёзную тревогу в обществе, в особенности в промышленности развлечений, где развитие технологий генерации видео влечёт массу негативных последствий, к примеру, для киностудий. Больше того, всё почаще подымается вопрос о том, что подобные Sora методы могут применяться для сотворения фейковых видео с ролью политиков и знаменитостей, что может привести к самым непредсказуемым последствиям.