Во вторник на конференции Гугл I/O 2024 была анонсирована новенькая возможность для ИИ-чат-бота Gemini — функция Gemini Live, которая позволяет юзерам новости «углубленные» голосовые диалоги с Gemini на собственных телефонах. Юзеры могут прерывать Gemini во время его реплик, чтоб задать уточняющие вопросы, и чат-бот будет приспособиться к речи юзера в режиме реального времени. Также, Gemini может созидать и реагировать на окружение юзера, используя фото либо видео, снятые камерами телефонов.

Gemini Live — это в неком роде соединение платформы компьютерного зрения Гугл Lens и виртуального ассистента Гугл Assistant, и их предстоящая развитие. На 1-ый взор Gemini Live не кажется кардинальным обновлением по сопоставлению с существующими технологиями. Но Гугл утверждает, что система употребляет новые способы генеративного ИИ, чтоб обеспечить отличный, наименее склонный ошибкам разбор изображений, и соединяет эти способы с усовершенствованным речевым движком для больше поочередного, чувствительно выразительного и близкого к реальности многооборотного диалога.

Технические новые технологии, применяемые в Gemini Live, отчасти связаны с проектом Проект Astra, новейшей инициативой DeepMind по созданию приложений и «агентов» на базе ИИ с поддержкой «осознания» в реальном времени разных источников данных — текста, аудио и изображения. «Мы постоянно желали сотворить универсального агента, который будет полезен в ежедневной жизни, — произнес на брифинге Демис Хассабис (Demis Hassabis), главный начальник DeepMind. — Представьте для себя агентов, которые могут созидать и слышать то, что мы делаем, лучше осознавать контекст, в каком мы находимся, и мгновенно реагировать в общении, делая темп и качество взаимодействия еще больше естественными».

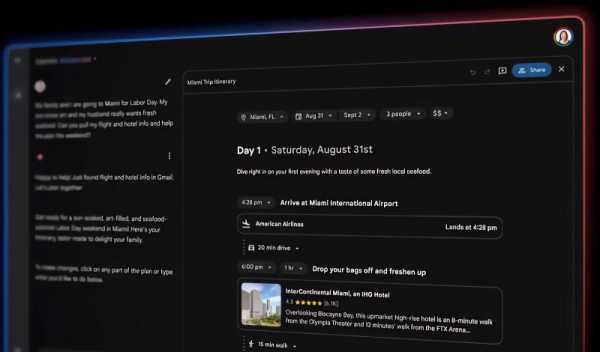

Gemini Live, который будет введен в эксплуатацию исключительно в конце этого года, сумеет давать ответ на вопросы о предметах, находящихся в поле зрения (либо не так давно попавших в поле зрения) камеры телефона, к примеру, в каком районе находится юзер либо как именуется сломавшаяся составляющая велика. Или юзер сумеет указать системе на часть компьютерного кода, а Live растолкует, за что она отвечает. А на вопрос о том, где могут быть очки юзера, Gemini Live произнесет, где он лицезрел их в крайний раз. Как это облегчит поиск потерянного пульта от телека!

Live также сумеет стать типичным виртуальным наставником, помогая юзерам отрепетировать речь к мероприятию, обмозговать идеи и так дальше. Live может намекнуть, какие способности следует акцентировать на дальнейшем собеседовании либо стажировке, либо дать совет по общественному выступлению.

Способность Gemini Live «запоминать», что происходило не так давно, стала вероятной благодаря архитектуре модели, лежащей в ее базе — Gemini 1.5 Проф, и еще, но в наименьшей степени, других «специфичных» генеративных моделей. У Gemini 1.5 Проф очень ёмкое контекстное окно, следовательно, она может принять и обработать огромное кол-во данных — около часа видео — сначала чем приготовить ответ. В Гугл отметили, что Gemini Live будет держать в голове всё, что происходило в последние часы.

Gemini Live припоминает генеративный ИИ, используемый в очках Meta✴, которые аналогичным образом могут просматривать изображения, снятые камерой, и толковать их почти в реальном времени. Судя по демонстрационным роликам, которые Гугл показала во время презентации, Live также очень похож на не так давно освеженный ChatGPT от OpenAI.

Ключевое отличие меж новым ChatGPT и Gemini Live состоит в том, что решение от Гугл не будет бесплатным. После пуска Live будет эксклюзивом для Gemini Продвинутый, больше трудной версии Gemini, которая доступна подписчикам плана Гугл One AI Премиум Plan, ценой 20 баксов за месяц.

Может-быть, в качестве отсылки к очкам Meta✴, в одном из демо роликов Гугл был показан человек в AR-очках, снаряженных приложением, схожим на Gemini Live. Истина, компания Гугл, желая избежать еще одного провала в сфере умных очков, отказалась сказать, появятся ли данный либо аналогичный продукт с генеративным ИИ на рынке в не далеком будущем.